Rajesh Rao es un hombre que cree que el mejor tipo de ayuda robótica es la que puede leer la mente. De hecho, es más que un defensor de los robots de control mental. Cree en entrenarlos a través del poder del pensamiento.

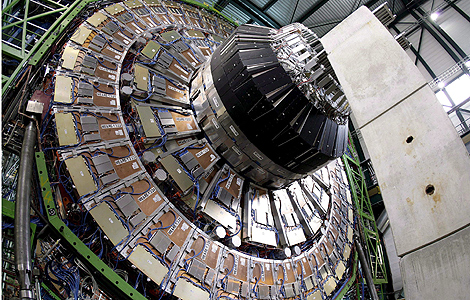

Su equipo en el Laboratorio de Sistemas Neuronales, en la Universidad de Washington, espera llevar la tecnología de interfaz cerebro-computadora (BCI, por sus siglas en inglés) a un nuevo nivel al intentar enseñarle a los robots nuevas habilidades a través de señales cerebrales.

Sustitutos robóticos que ofrezcan a personas paralizadas la libertad para explorar su ambiente, manipular objetos, o simplemente buscar cosas ha sido el santo grial de la investigación sobre la BCI durante mucho tiempo.

El equipo de Rao comenzó con la programación de un robot humanoide de comportamientos simples que los usuarios podían seleccionar con un electroencefalograma (EEG) que recogía su actividad cerebral.

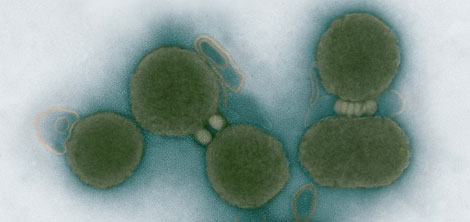

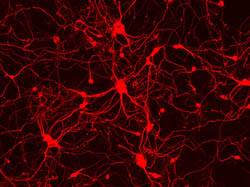

El cerebro genera lo que se conoce como P300, o P3, una señal involuntaria cada vez que se reconoce un objeto. Esta señal es causada por millones de neuronas que trabajan juntas de una manera sincronizada.

Esto ha sido utilizado por muchos investigadores en todo el mundo para crear aplicaciones basadas en la BCI que permiten al usuario escribir una palabra, identificar imágenes, seleccionar botones en un entorno virtual y, más recientemente, incluso tocar en una orquesta o enviar un mensaje de Twitter.

La meta inicial del equipo de científicos era que el usuario enviara una orden al robot para que la procesara en un movimiento, explica Lakshmi Sandhana, periodista especializado en tecnología.

Sin embargo, esto requiere que el robot esté programado con un conjunto predefinido de comportamientos muy básicos, un enfoque que el Dr. Rao encontró que era muy limitante.

El equipo pensó luego que darle al robot la capacidad de aprender podía ser el truco para permitir un mayor rango de movimientos y respuestas.

"¿Qué pasa si el usuario quiere que el robot haga algo nuevo?", se pregunta Rao.

La respuesta, dice, es aprovechar el sistema "jerárquico" del cerebro, utilizado para controlar el cuerpo.

"Un comportamiento inicialmente enseñado por el usuario es transferido en un comando de más alto nivel. Cuando se lo invoca más tarde, los detalles del comportamiento son manejados por el robot", explica Rao.

"Mitra", un amigo

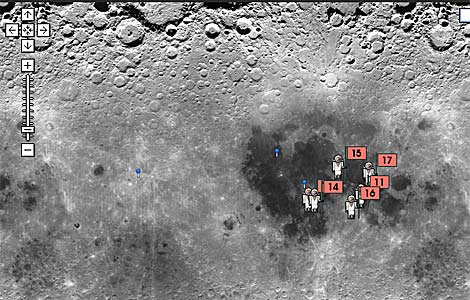

El último prototipo de Rao es "Mitra", que significa "amigo". Es un humanoide de 60cm de altura que puede caminar y buscar, recoger y dejar objetos familiares.

El equipo está construyendo un BCI que se puede utilizar en entrenar a "Mitra" para caminar hacia diferentes ubicaciones dentro de una habitación.

Una vez que una persona se coloca el EEG puede elegir entre enseñar al robot una nueva habilidad o ejecutar un comando ya conocido a través de un menú.

Si el robot aprende el nuevo comportamiento, el usuario puede pedir al sistema que almacene el nuevo comando de alto nivel que aparecerá en la lista de opciones disponibles la próxima vez.

"El sistema resultante es a la vez de adaptación y jerárquico. De adaptación, ya que aprende del usuario y jerárquico porque los nuevos comandos se pueden componer como secuencias de comandos que ha aprendido", dice Rao.

El principal desafío en este momento es conseguir que el sistema sea exacto.

"El EEG se puede utilizar para enseñar habilidades sencillas a un robot como dirigirse a una nueva ubicación, pero no esperamos ser capaces de enseñarle a los robots habilidades complejas que implican manipulación fina, como abrir un frasco de medicina o atarse los cordones", agrega el doctor.

Podría ser posible alcanzar un mayor grado de control mediante la utilización de una BCI invasiva o permitiéndole al usuario seleccionar videos de acciones humanas que el robot puede intentar aprender.

Un esfuerzo paralelo en el mismo laboratorio está centrado en algoritmos de aprendizaje basados en la imitación, que permitirían al robot imitar acciones complejas, tales como patear una pelota o levantar objetos viendo un ser humano hacer la tarea.

Su equipo en el Laboratorio de Sistemas Neuronales, en la Universidad de Washington, espera llevar la tecnología de interfaz cerebro-computadora (BCI, por sus siglas en inglés) a un nuevo nivel al intentar enseñarle a los robots nuevas habilidades a través de señales cerebrales.

Sustitutos robóticos que ofrezcan a personas paralizadas la libertad para explorar su ambiente, manipular objetos, o simplemente buscar cosas ha sido el santo grial de la investigación sobre la BCI durante mucho tiempo.

El equipo de Rao comenzó con la programación de un robot humanoide de comportamientos simples que los usuarios podían seleccionar con un electroencefalograma (EEG) que recogía su actividad cerebral.

El cerebro genera lo que se conoce como P300, o P3, una señal involuntaria cada vez que se reconoce un objeto. Esta señal es causada por millones de neuronas que trabajan juntas de una manera sincronizada.

Esto ha sido utilizado por muchos investigadores en todo el mundo para crear aplicaciones basadas en la BCI que permiten al usuario escribir una palabra, identificar imágenes, seleccionar botones en un entorno virtual y, más recientemente, incluso tocar en una orquesta o enviar un mensaje de Twitter.

La meta inicial del equipo de científicos era que el usuario enviara una orden al robot para que la procesara en un movimiento, explica Lakshmi Sandhana, periodista especializado en tecnología.

Sin embargo, esto requiere que el robot esté programado con un conjunto predefinido de comportamientos muy básicos, un enfoque que el Dr. Rao encontró que era muy limitante.

El equipo pensó luego que darle al robot la capacidad de aprender podía ser el truco para permitir un mayor rango de movimientos y respuestas.

"¿Qué pasa si el usuario quiere que el robot haga algo nuevo?", se pregunta Rao.

La respuesta, dice, es aprovechar el sistema "jerárquico" del cerebro, utilizado para controlar el cuerpo.

"Un comportamiento inicialmente enseñado por el usuario es transferido en un comando de más alto nivel. Cuando se lo invoca más tarde, los detalles del comportamiento son manejados por el robot", explica Rao.

"Mitra", un amigo

El último prototipo de Rao es "Mitra", que significa "amigo". Es un humanoide de 60cm de altura que puede caminar y buscar, recoger y dejar objetos familiares.

El equipo está construyendo un BCI que se puede utilizar en entrenar a "Mitra" para caminar hacia diferentes ubicaciones dentro de una habitación.

Una vez que una persona se coloca el EEG puede elegir entre enseñar al robot una nueva habilidad o ejecutar un comando ya conocido a través de un menú.

Si el robot aprende el nuevo comportamiento, el usuario puede pedir al sistema que almacene el nuevo comando de alto nivel que aparecerá en la lista de opciones disponibles la próxima vez.

"El sistema resultante es a la vez de adaptación y jerárquico. De adaptación, ya que aprende del usuario y jerárquico porque los nuevos comandos se pueden componer como secuencias de comandos que ha aprendido", dice Rao.

El principal desafío en este momento es conseguir que el sistema sea exacto.

"El EEG se puede utilizar para enseñar habilidades sencillas a un robot como dirigirse a una nueva ubicación, pero no esperamos ser capaces de enseñarle a los robots habilidades complejas que implican manipulación fina, como abrir un frasco de medicina o atarse los cordones", agrega el doctor.

Podría ser posible alcanzar un mayor grado de control mediante la utilización de una BCI invasiva o permitiéndole al usuario seleccionar videos de acciones humanas que el robot puede intentar aprender.

Un esfuerzo paralelo en el mismo laboratorio está centrado en algoritmos de aprendizaje basados en la imitación, que permitirían al robot imitar acciones complejas, tales como patear una pelota o levantar objetos viendo un ser humano hacer la tarea.

Una serie de grupos intentan crear robots controlados a través de la mente para varias aplicaciones:

Este año Honda demostró cómo su robot Asimo era capaz de levantar un brazo o mover una pierna a través de señales enviadas desde un electroencefalograma operado por un usuario.

Científicos de la Universidad de Zaragoza (España) trabajan en crear sillas de ruedas robóticas que puedan ser manejadas con el pensamiento.