Una investigación oficial determinó que la falla fue causada por una conexión eléctrica defectuosa que originó la liberación de gas helio, el cual dañó 53 superconductores magnéticos.

En noviembre pasado, el Centro Europeo de Investigaciones Nucleares (CERN, por sus siglas en inglés) confirmó que la llamada "Máquina de Dios" no volverá a arrancar antes del verano boreal de 2009.

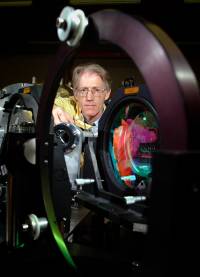

El Gran Colisionador de Hadrones, (LHC, por sus siglas en inglés) entró en funcionamiento el pasado 10 de septiembre cuando los científicos lograron que el primer haz de protones diera una vuelta completa por el túnel de 27 kilómetros de circunferencia instalado bajo la frontera suizo-francesa, en las afueras de Ginebra.

Pero sólo 10 días después, una avería hizo que se tuviera que retrasar el experimento.

Gradual

De acuerdo con el periodista de la BBC Pallab Ghosh, la investigación sobre las fallas sufridas por el equipo recomendó la instalación de un sistema de alarma para detectar posibles escapes de helio durante las fases iniciales.

El informe, elaborado por el CERN, dice que la introducción de mejoras en las válvulas de salida de gas a presión podría evitar averías como la ocurrida en septiembre pasado.

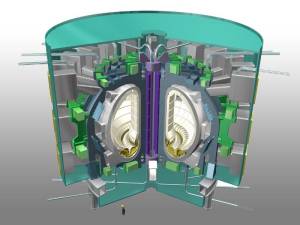

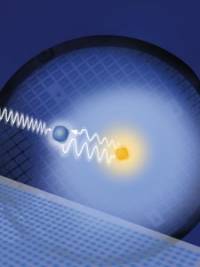

El Gran Colisionador de Hadrones utiliza una serie de imanes para acelerar protones -pequeñísimas partículas subatómicas- a velocidades extremadamente rápidas.

De esa manera se intenta recrear las condiciones en que se encontraba el universo fracciones de segundo después de lo que se conoce como Big Bang, o Gran Explosión, una teoría que trata de explicar la formación del universo hace más de 13.000 millones de años.

Ahora, los científicos decidieron poner en funcionamiento el acelerador de partículas de una manera mucho más gradual.

El doctor Francisco Bertinelli, uno de los expertos que está reparando la avería, aseguró: "No reiniciaremos el acelerador desde cero hasta su máxima velocidad en una tarde. Iremos ganando confianza paulatinamente de modo que reduzcamos los riesgos".

BBC Mundo Ciencia y Tecnología Alta suma para la "Máquina de Dios"